Virtuelle Systeme bieten ganz reale Vorteile

Nutzungsvorteile führen zu neuen Virtualisierungsprojekten: An oberster Stelle stehen Disaster-Recovery und Business-Continuity

Hervorragend für die Verbesserung der Systemverfügbarkeit: Virtuelle Systeme erlauben einen schnellen Restart nach einem Systemausfall erlauben

(30.11.09) - Mit Virtualisierungstechnologien werden die IT-Ressourcen besser genutzt und die Flexibilität zur Anpassung an neue Anforderungen und Arbeitsbelastungen steigt. Mit der Hinzufügung von Automatisierungstechnologien könne darüber hinaus die Effektivität aller IT-Ressourcen dramatisch verbessert werden. Doch was verbirgt sich hinter dem Begriff Virtualisierung sowie den zugehörigen Märkten und Systemen?

Der gemeinsame Nenner über alle Interpretationen in der professionellen IT-Welt hinweg ist der, dass man mit Hilfe von Virtualisierung verschiedene – eben virtuelle – Systeme auf ein und derselben Hardware betreiben kann. Und in einer etwas neueren Definition bedeutet Virtualisierung auch das Gegenteil, dass also eine logische Einheit über mehrere Hardware-Systeme verteilt sein kann. Schlussendlich ist es die totale Trennung von logischer und physischer Ebene. Damit ist zwar einiges gesagt, aber auch vieles noch offen.

Ein Hypervisor macht noch kein dynamisches RZ

So bedeutet das Wort "Systeme" in diesem Fall entweder Server, Storage, Netzwerk oder Desktop. Und damit wird schlagartig deutlich, wie weit der Begriff Virtualisierung reicht. Die Server-Virtualisierung gilt inzwischen als eine Art Allround-Lösung für alle gegenwärtigen und zukünftigen Rechenzentrumsprobleme. Doch noch hat sie ihre Grenzen.

Die Mindestanforderung an eine Server-Virtualisierung ist ein so genannter Hypervisor, der auf der einen Seite mit der Hardware und auf der anderen Seite mit dem Betriebssystem kommuniziert. Der Hypervisor ist zwar wichtig, ist aber nur ein Teil der Lösung. Er erlaubt zwar die logische Partitionierung eines physischen Servers – doch das ist bei Weitem nicht das, was die erheblichen Einsparungen bei der Virtualisierung ausmachen. Erst das damit einhergehende Managen der Server, die zugehörigen Backups und Restart-Prozeduren und letztlich das unterbrechungsfreie Verschieben einer Anwendungen von einem logischen Server auf einen anderen machen in Verbindung mit Storage- und Netz-Virtualisierung diese Technologie so besonders attraktiv.

Knapp gesagt: Das Betreiben von vielen virtuellen Servern auf einem physischen erlaubt einen annähernd automatischen RZ-Betrieb und erhöht darüber hinaus die Auslastung des Systems, was wiederum zu Maintenance- und Energieeinsparungen führt. Das sind die wesentlichen Kosteneinsparungen von denen alle reden. Doch um das zu erreichen, bedarf es eines umfangreichen Softwarepaketes, das weit über den Hypervisor hinausgeht.

Auch für Forrester-Analyst Frank Gillet hängt die weitere Akzeptanz der Virtualisierung bei den IT-Chefs davon ab, in wie weit sich diese Technologie in das Gesamtsystem einfügen und administrieren lässt. "Es geht überhaupt nicht darum, welchen Hypervisor man benutzt, sondern vielmehr darum, welches Ökosystem man für das Management einsetzt", lautet seine Feststellung. Somit seien die zugehörigen Management-Tools für den Erfolg der Virtualisierung viel wichtiger als die Technologie an sich.

Virtualisierung für High-Performance-Umgebungen?

Dass erst die oberhalb des Hypervisors liegenden Schichten über den Sinn und den Nutzen einer Virtualisierung entscheiden, bedeutet aber auch, dass es viele Anwendungen gibt, die sich (noch) nicht besonders gut zur Virtualisierung eignen. "Alle CIOs lesen von Virtualisierung und meinen, man muss nur einen Schalter umlegen um damit viel Geld zu sparen, doch das ist leider nicht der Fall", sagt Yankee-Analystin Gery Chen. Als nicht virtualisierungsgeeignet hält sie beispielsweise High-Performance-Datenbanken oder auch stark zentralisierte Anwendungen.

Virtuell ausfallsicher

Zusätzliche, bislang unberücksichtigte, Nutzungsvorteile könnten den Einsatz der Virtualisierungstechnologie ebenfalls voran bringen. Gemäß einer neuen Forrester-Untersuchung meinen rund die Hälfte der Unternehmen, die bereits eine Server-Virtualisierung installiert haben, dass sie im Anschluss daran weitere Nutzungsvorteile erkannt hätten, die zu neuen Virtualisierungsprojekten führen würden. An oberster Stelle stehen dabei Disaster-Recovery und Business-Continuity.

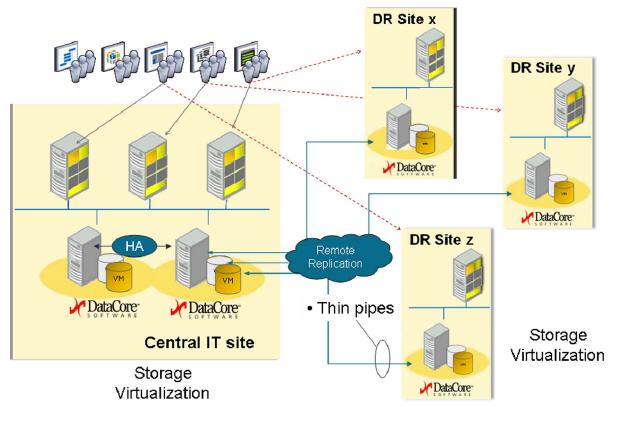

Da virtuelle Systeme einen schnellen – häufig sogar einen automatischen – Restart nach einem Systemausfall erlauben, eignet sich diese Technologie hervorragend für eine Verbesserung der Systemverfügbarkeit. In Verbindung mit Datenreplikation zwischen verschiedenen Rechenzentren bietet diese Technologie eine äußerst zuverlässige IT-Infrastruktur für Disaster-Recovery und Mission-Critical-Applikationen. Läuft beispielsweise auf einem physischer Server eine wichtige Anwendung, so beschränkt sich die Ausfallzeit auf den Zeitraum vom Entdecken des Problems bis zum erfolgreichen Neustart der Anwendung auf einem anderen verfügbaren Server.

Doch es gibt keine bahnbrechend neue Technologie ohne Schattenseiten. So kommt die größte Kritik an der Server-Virtualisierung gegenwärtig von den Sicherheitsexperten. Einige meinen, dass ein in einer virtuellen Umgebung verpackter Rootkit die absolute Bedrohung darstellt, da er niemals erkannt werden kann. Vergangenes Jahr hatte die Malware-Forscherin Joanna Rutkowska behauptet, ein absolut unauffindbares Hypervisor-Rootkit namens Blue Pill entwickelt zu haben.

Doch diese "transparenten VMMs" (Virtual Machine Monitor) sind nur ein Mythos. So haben Wissenschaftler der Carnegie Mellon University (CMU) und Stanford University jetzt herausgefunden, dass eine absolute Transparenz nicht möglich ist. Nach Testläufen mit den Virtualisierungs-Technologien von VMware und Xensource kommen sie zu dem Ergebnis, dass sich schädliche Rootkits auch dann aufspüren lassen, wenn sie mit Hypervisor-Technologie versteckt wurden. "Egal wie minimal schädlich ein bösartiger VMM ist, er muss in jedem Fall gewisse physische Ressourcen benutzen. Und damit ist das Schadprogramm letztendlich immer aufspürbar", heißt es in dem Forschungsbericht.

Trotz der zunehmenden Akzeptanz von Virtualisierung bei den Servern wird sich das vorläufig nicht auf den Hardware-Absatz auswirken. So meinen die Analysten von Standard & Poors, dass die Virtualisierung noch kein Grund für einen Wachstums-Stopp bei den Servern sei, da die zunehmenden IT-Aufgaben und -Anwendungen auch zusätzliche Hardware benötigen werden. Allerdings gibt es eine deutliche Verschiebung bei der Server-Beschaffung. "Es gibt einen eindeutigen Trend zu weniger – dafür aber größeren und teureren Systemen – der sich nur mit zunehmender Virtualisierung erklären lässt", sagt IDC-Analyst Jed Scaramella.

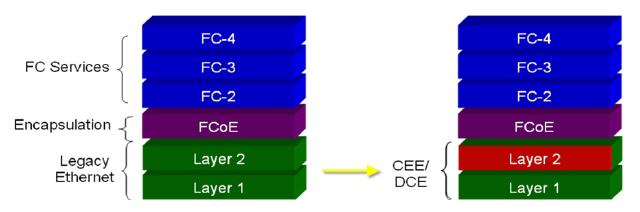

Ergänzt wird der Trend zur Server-Virtualisierung von parallelen Entwicklungen beim Storage, den Netzen und bei den Desktops. Bei der Storage-Virtualisierung ist es ähnlich wie bei der Server-Virtualisierung: Völlige Trennung von logischen und physischen Einheiten. Entsprechend der zu Grunde liegenden Technologie unterscheidet man hier die SAN-Virtualisierung, die eine unterbrechungsfreie Datenmobilität zwischen den Storage-Areas ermöglicht, das bedeutet eine höhere Unabhängigkeit zwischen Storage- und Server-Betrieb.

Mit der File-Virtualisierung lassen sich Dateien auf unterschiedlichen Systemen zusammenfassen, und wenn ganze File-Systeme virtualisiert werden, entstehen hochperformante, flexible NAS-Umgebungen. Eine Besonderheit der Storage-Virtualisierung sind virtuelle Bandlaufwerke. Dabei werden ganze Tape-Bibliotheken auf einer Festplatte emuliert. Das verkürzt den Backup und das Recovery ganz erheblich. (EMC: ra)

EMC Deutschland GmbH

Frank Gülpen

Am Kronberger Hang 2a, 65824 Schwalbach/Taunus

Telefon (0 61 96) 47 28 - 240; Telefax (0 61 96) 47 28 - 218